课程链接:https://learn.deeplearning.ai/courses/evaluating-debugging-generative-ai/lesson/t7eoa/introduction

github链接:https://github.com/MSzgy/Evaluating-and-Debugging-Generative-AI

Introduction

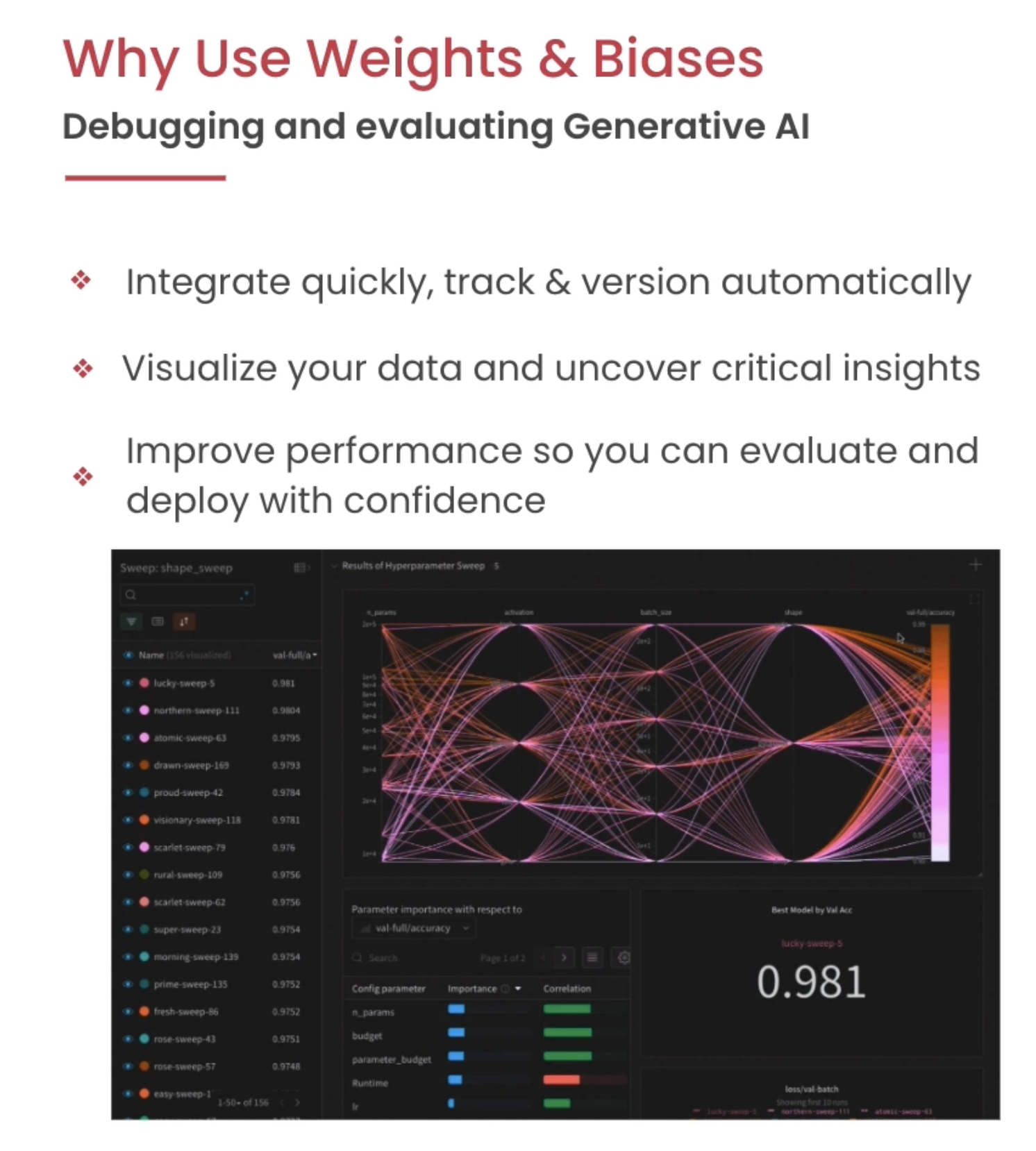

本课程介绍一种Generative AI 的评估以及tracking方式,它的主要目标是帮助AI研发者更准确、更有效地创建和调试他们的生成模型。可以记录相关实验过程以及模型的lifecycle。

Instrument W&B

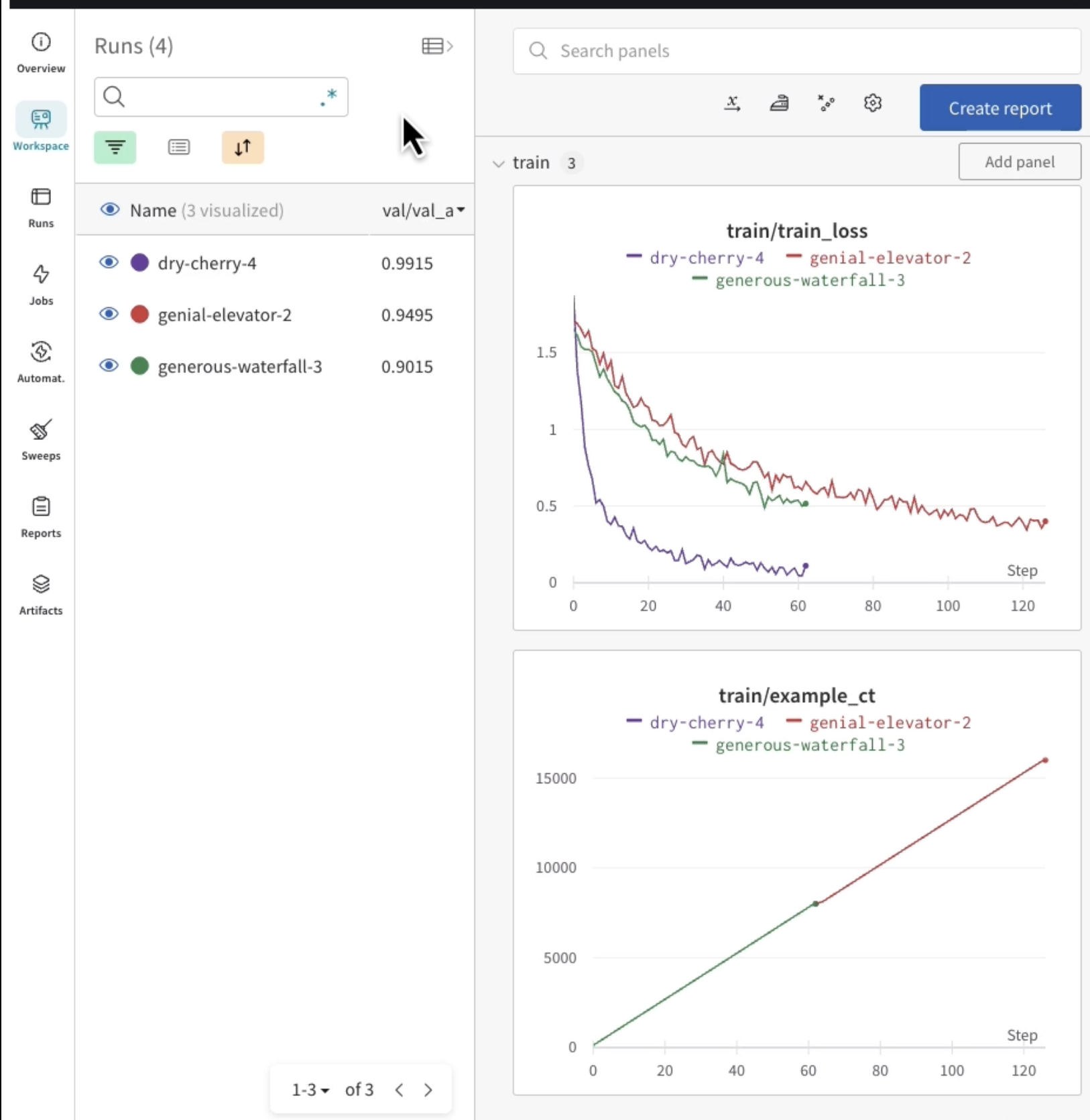

W&B dashboard可以看到很多的metrics并且做相关分析,但是并不建议直接使用官网的,因为有隐私问题,可以直接使用本地搭建的W&B分析平台。

W&B dashboard可以看到很多的metrics并且做相关分析,但是并不建议直接使用官网的,因为有隐私问题,可以直接使用本地搭建的W&B分析平台。

Training a Difussion Model with W&B

在这节,以Difussion model的训练举例,做了一下工作:

Logging of the training loss and metrics

Sampling from the model during training and uploading the samples to W&B

Saving the model checkpoints to W&B

Evaluating Difussion Models

在本节,首先谈了Model Registry话题,然后可以在dashboard查看生成的具体图片。

LLM Evaluation and Tracing with W&B

在本节介绍了W&B可以追溯LLM app的整个过程,查看各个阶段的输入输出表现,便于debug。代码中也举了个Langchain agent的例子。详细分析了该模型在不同情况下的运行情况,并展示了如何利用W&B工具进行有效的问题定位和解决。

Finetuning a language model