课程链接:https://learn.deeplearning.ai/courses/ai-agents-in-langgraph/lesson/1/introduction

github:https://github.com/MSzgy/AI-Agents-in-LangGraph

Introduction

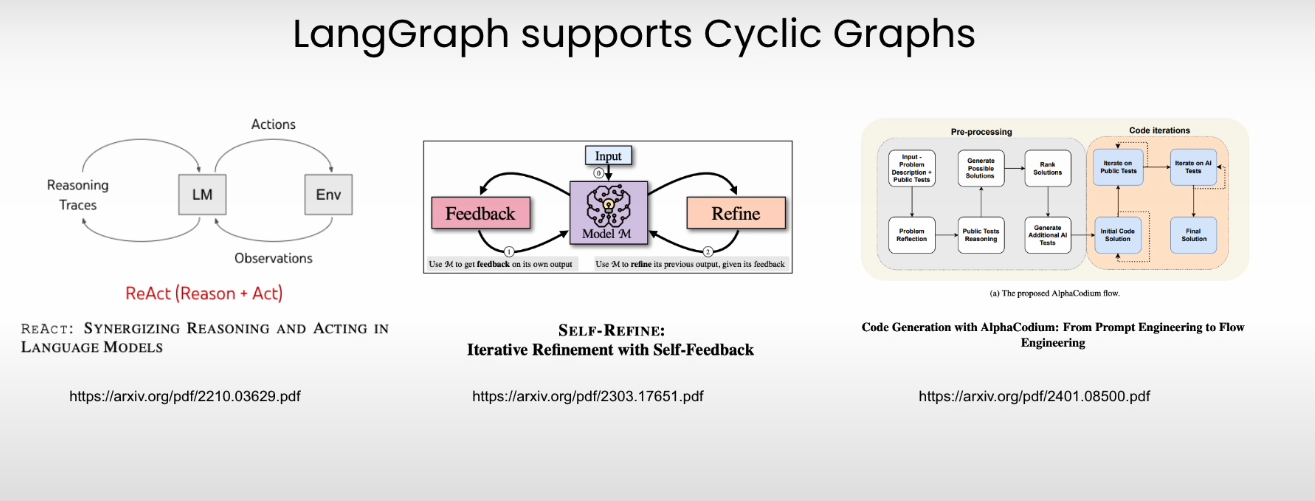

介绍了LangGraph的几种场景。

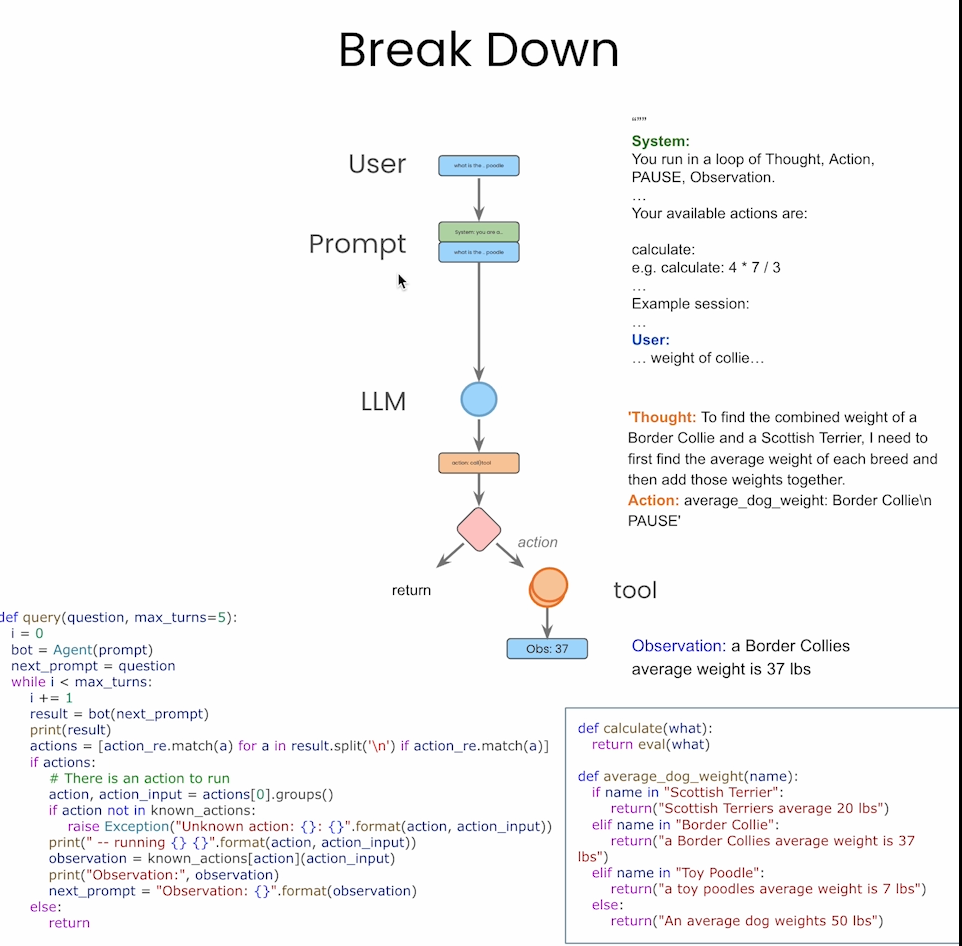

Build an Agent from Scratch

在这节,将会构建一个由LLM和function组成的Agent,采用ReAct形式(Reason + Act),包含Actions + Observations。

LangGraph Components

将上节讲的Agnent给分解会有如下几个步骤,但是框架需要我们自己搭建,如果碰到复杂的Agent流,就很繁琐。但从视频看来,个人认为LangGraph并没有CrewAI Agent功能强大且方便。

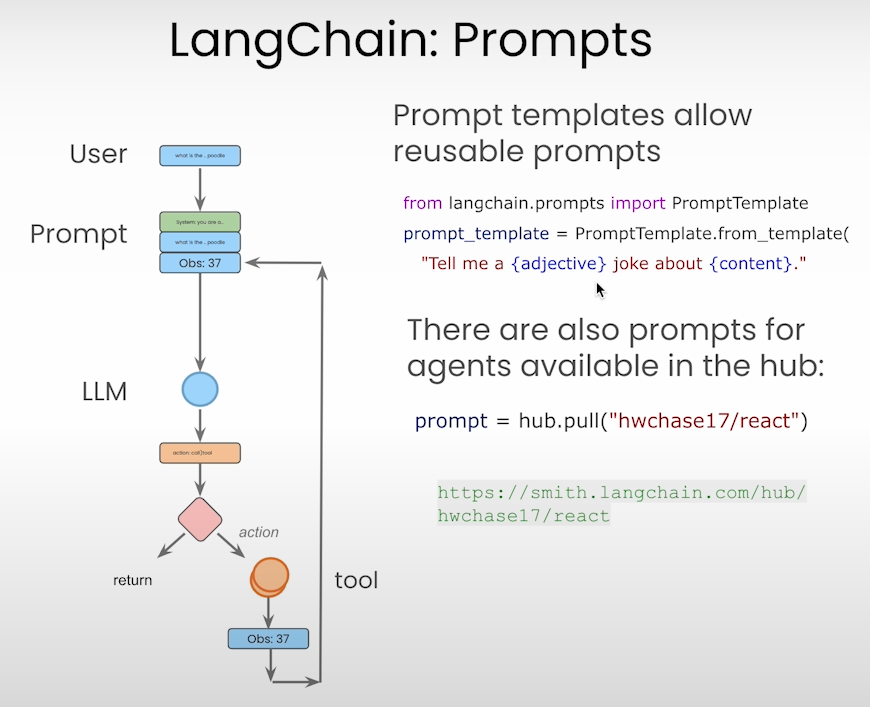

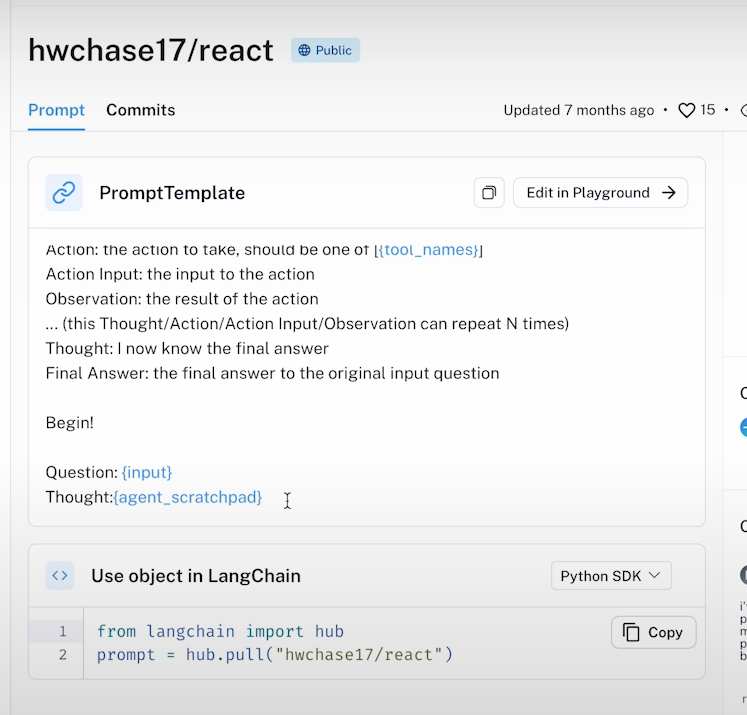

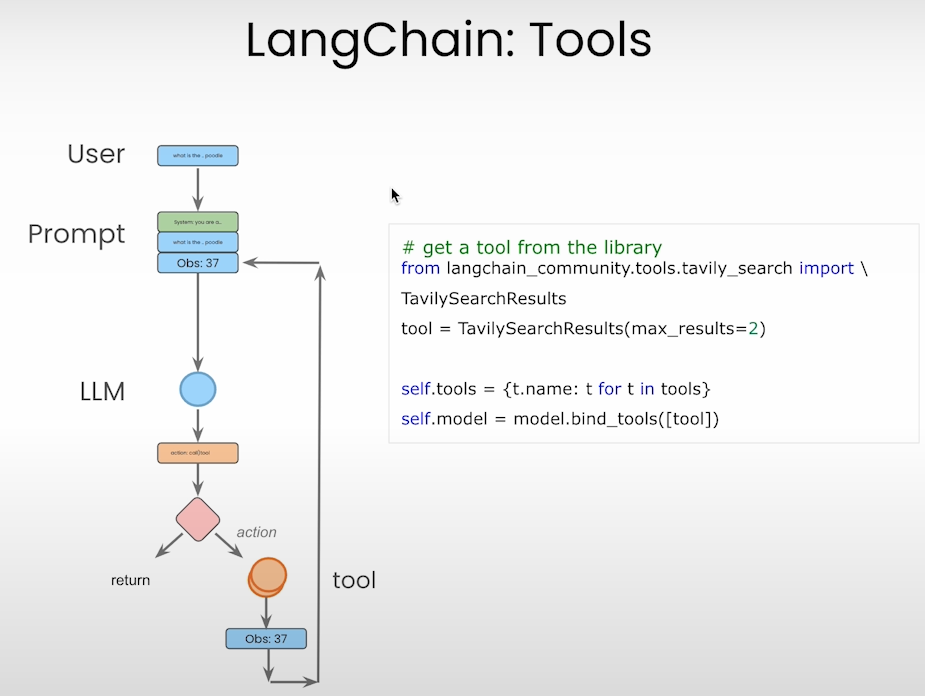

下面图提供了LangChain里面的Agents组件

组件1:Prompts template

组件2:Tools

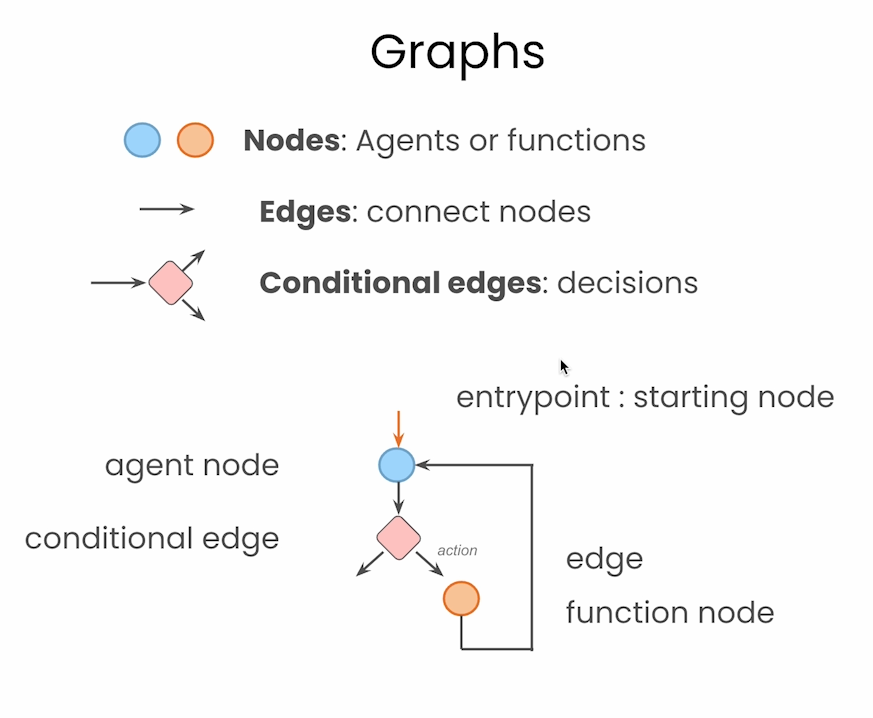

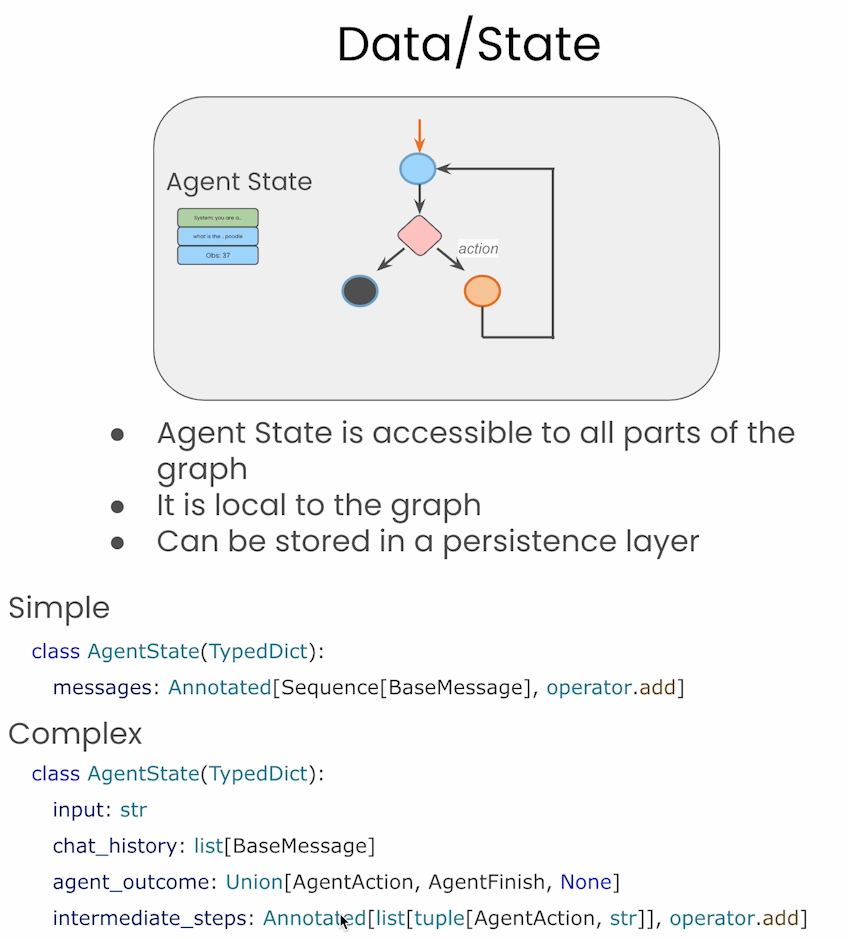

图中节点类型

图中的状态信息。

Agentic Search Tools

在本节使用了Tavily作为搜索引擎。

Tavily 是一款专为大型语言模型(LLM)和检索增强生成(RAG)应用优化的搜索引擎,旨在为人工智能代理提供高效、快速且持久的搜索结果。

主要功能:

• 实时信息检索:通过 Tavily Search API,AI 开发者可以将应用程序与实时在线信息集成,获取来自可信来源的准确数据,从而提高 AI 生成内容的准确性和可靠性。

• 优化的搜索结果:Tavily 提供快速响应,返回每个页面的精炼摘要,并附带与查询相关的图像,提升用户体验。

• 多源信息整合:与其他搜索 API(如 Bing、Google 和 SerpAPI)相比,Tavily 审查多个来源,从每个来源中提取最相关的内容,优化 LLM 的上下文。

适用对象:

Tavily 适用于 AI 开发者、研究人员以及需要实时、准确信息的企业,特别是那些使用 LLM 和 RAG 技术的用户,可从 Tavily 提供的精确和实时信息检索中受益。

集成与使用:

Tavily 提供 Python SDK,方便开发者在 Python 程序中与 Tavily API 交互,支持基本和高级搜索功能。 此外,Tavily 与 LangChain 和 LlamaIndex 等平台集成,提供文档和教程,帮助用户开始使用和集成 Tavily 服务。

定价计划:

Tavily 提供多种计划,以满足不同规模的使用需求,包括免费的研究者计划和付费的 Bootstrap、Startup 计划,提供更多的 API 调用次数和定制化的主题及来源。

总而言之,Tavily 是一款专为 AI 应用设计的搜索引擎,通过提供实时、准确的搜索结果,帮助 AI 系统减少幻觉和偏见,提升决策能力。

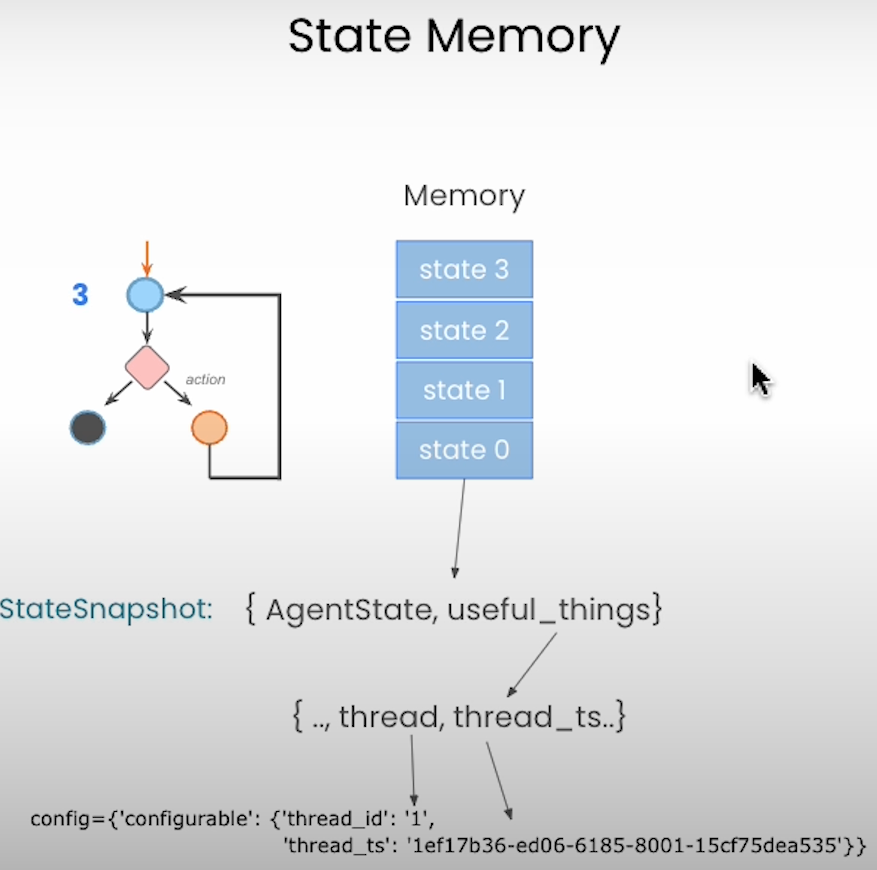

Persistence and Streaming

在于LLM对话时,需要保证以前记忆的持久性,因此在这节,介绍了LangGraph中的persistence。

Human in the loop

Agent会保存每个时刻的memory,并且通过sdk 可以改变state中的信息。

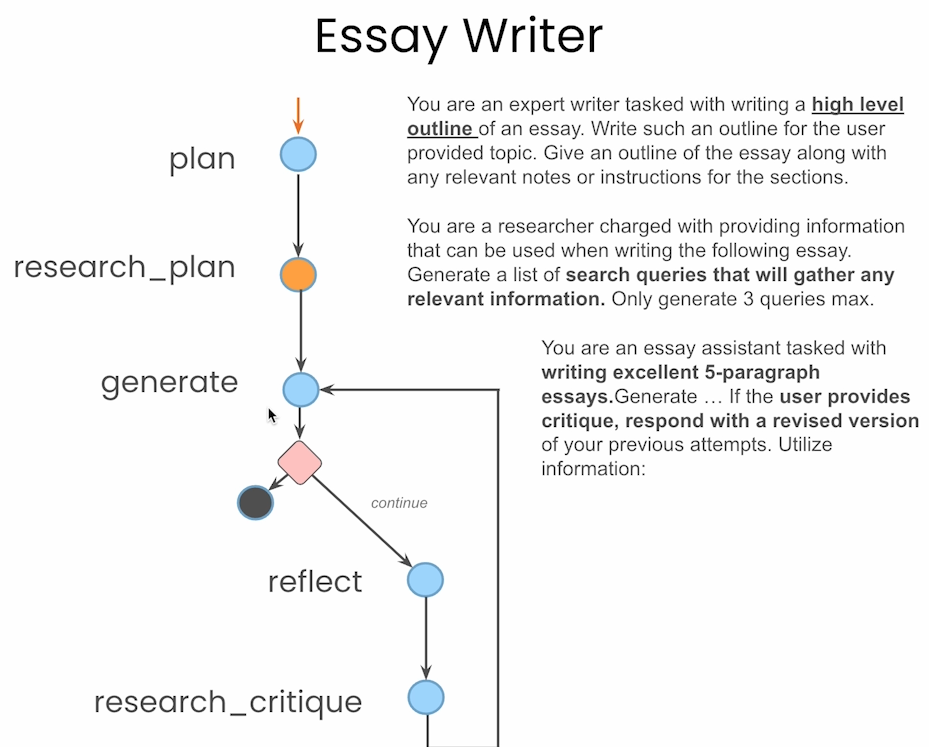

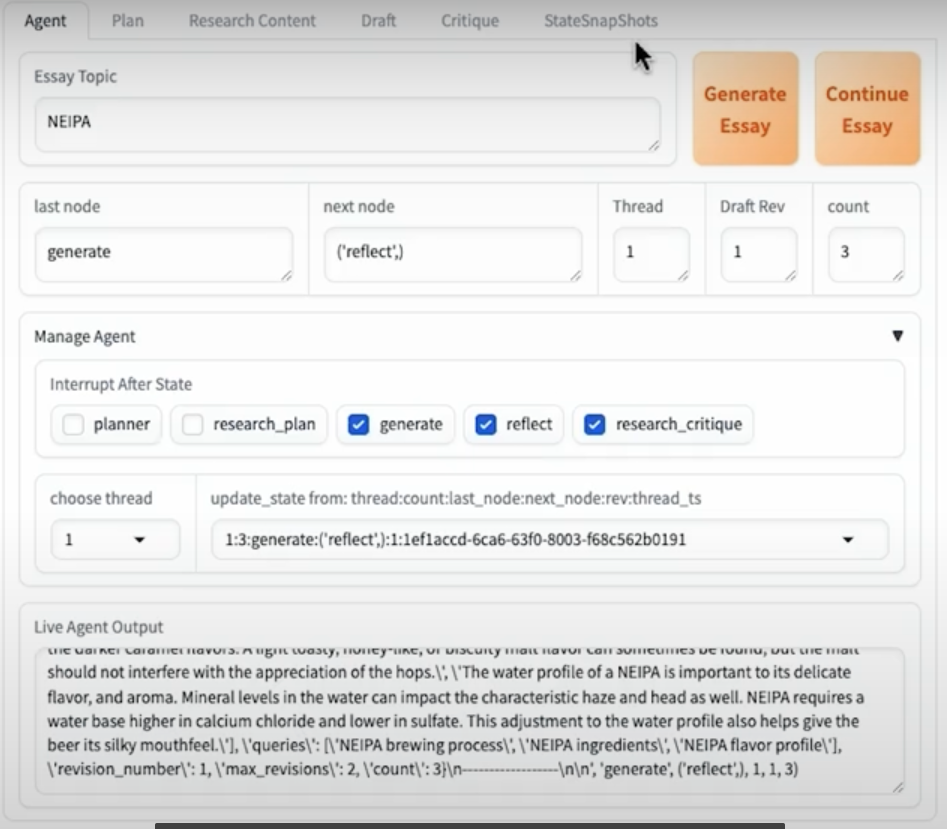

Eassy Writer

在这节,举了个demo,可以生成相应的论文,并使用了gradio作为UI搭建了个app。具体有下图中的几个步骤。这里重点提下reflect(反思):

reflect 在 Agent 场景中的作用,通常是让 Agent 对自身的思考过程或先前的决策进行回顾和审视,以便在下一步行动中做出改进或校正。具体体现为:

1. 自我检查与纠错:

Agent 可以在执行步骤后通过 reflect 回顾先前的逻辑和推理过程,发现逻辑漏洞、不合理的推断或潜在错误,从而在后续步骤中加以更正。

2. 适应复杂情境:

在复杂任务中,Agent 可能需要分解问题、不断调整策略。reflect 允许 Agent 在任务执行过程中对自身的策略进行动态评估,根据当前反馈和上下文变化进行适当的策略更新。

3. 提高决策质量:

通过反思(reflect),Agent 能够不断改善自身决策的整体质量,使得最终输出更具有连贯性、正确性和可靠性,增强对话或任务处理的智能性和稳定性。

简单来说,reflect 的作用就是让 Agent 有机会“回头看看”自己走过的路、思考过的逻辑,从而在下一步中做得更好。